level 11

爱吃皇堡

楼主

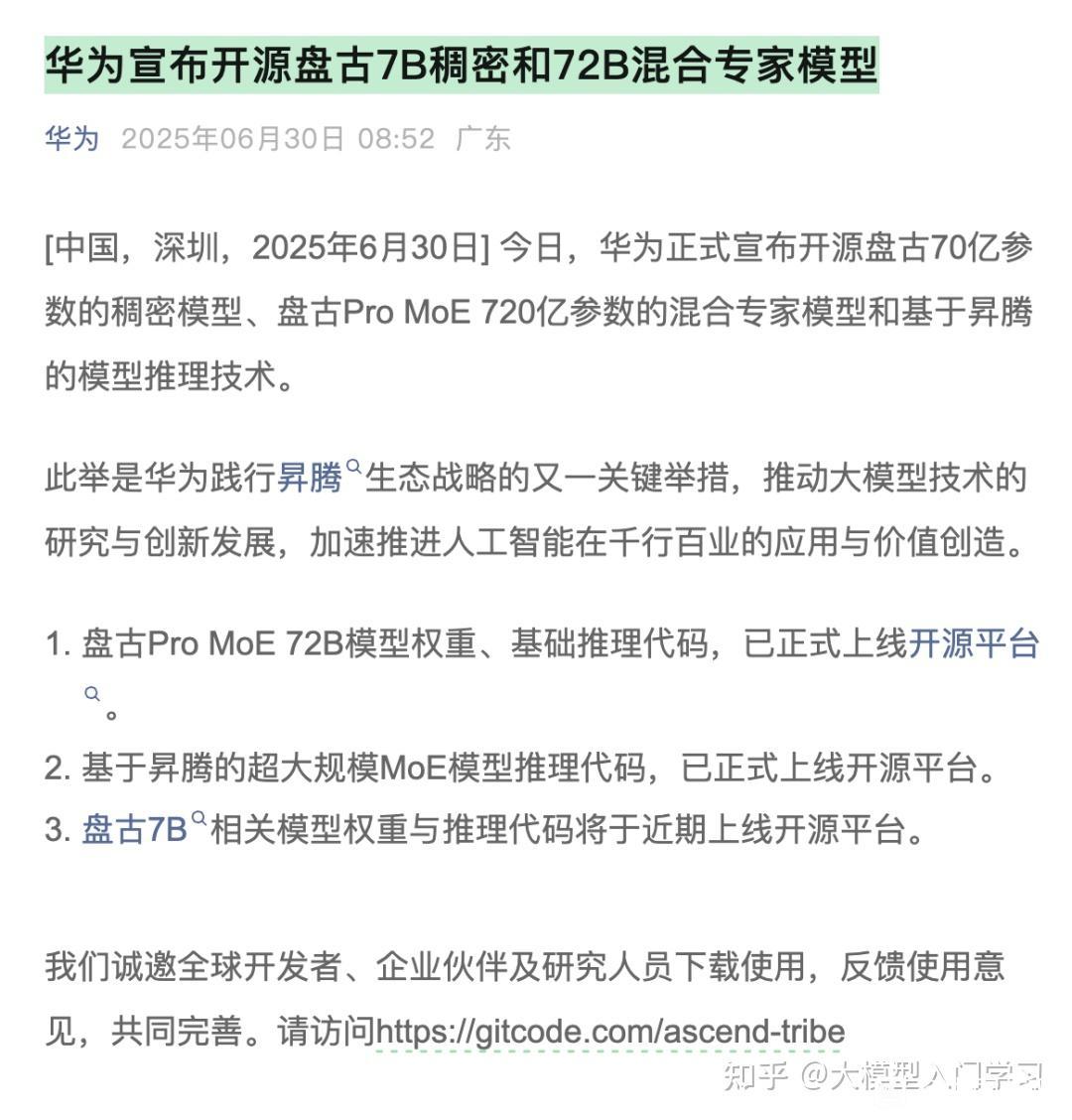

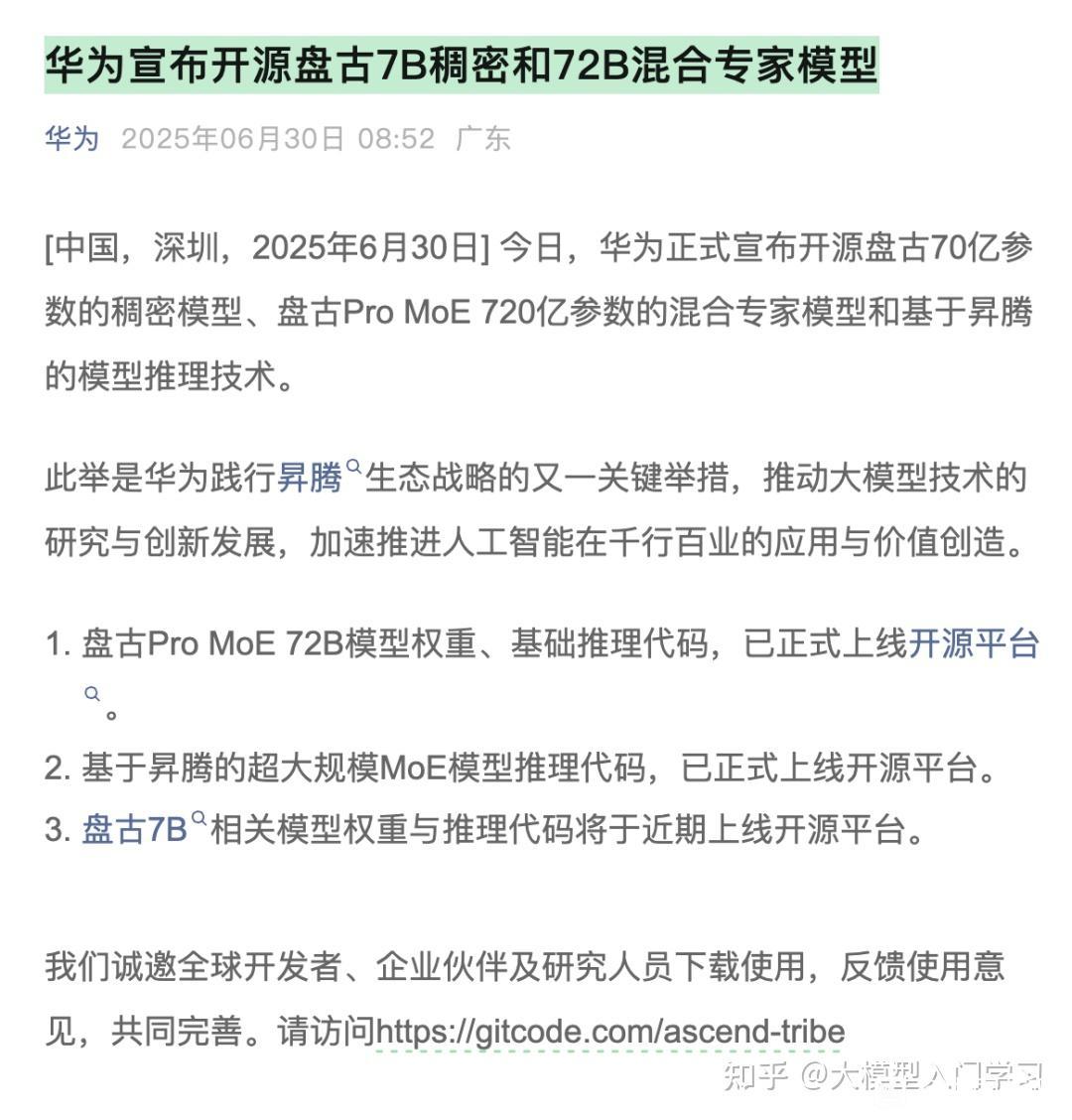

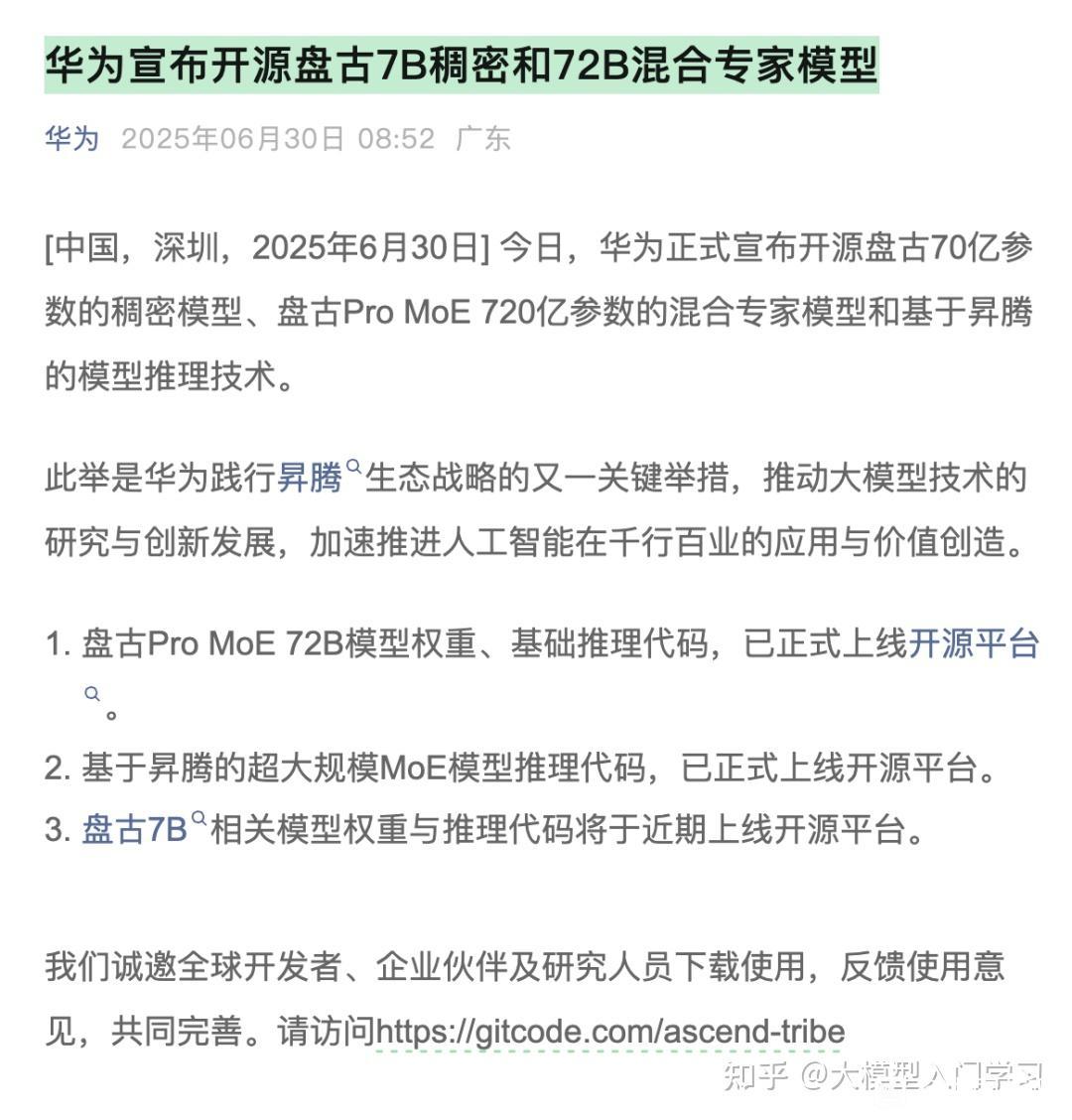

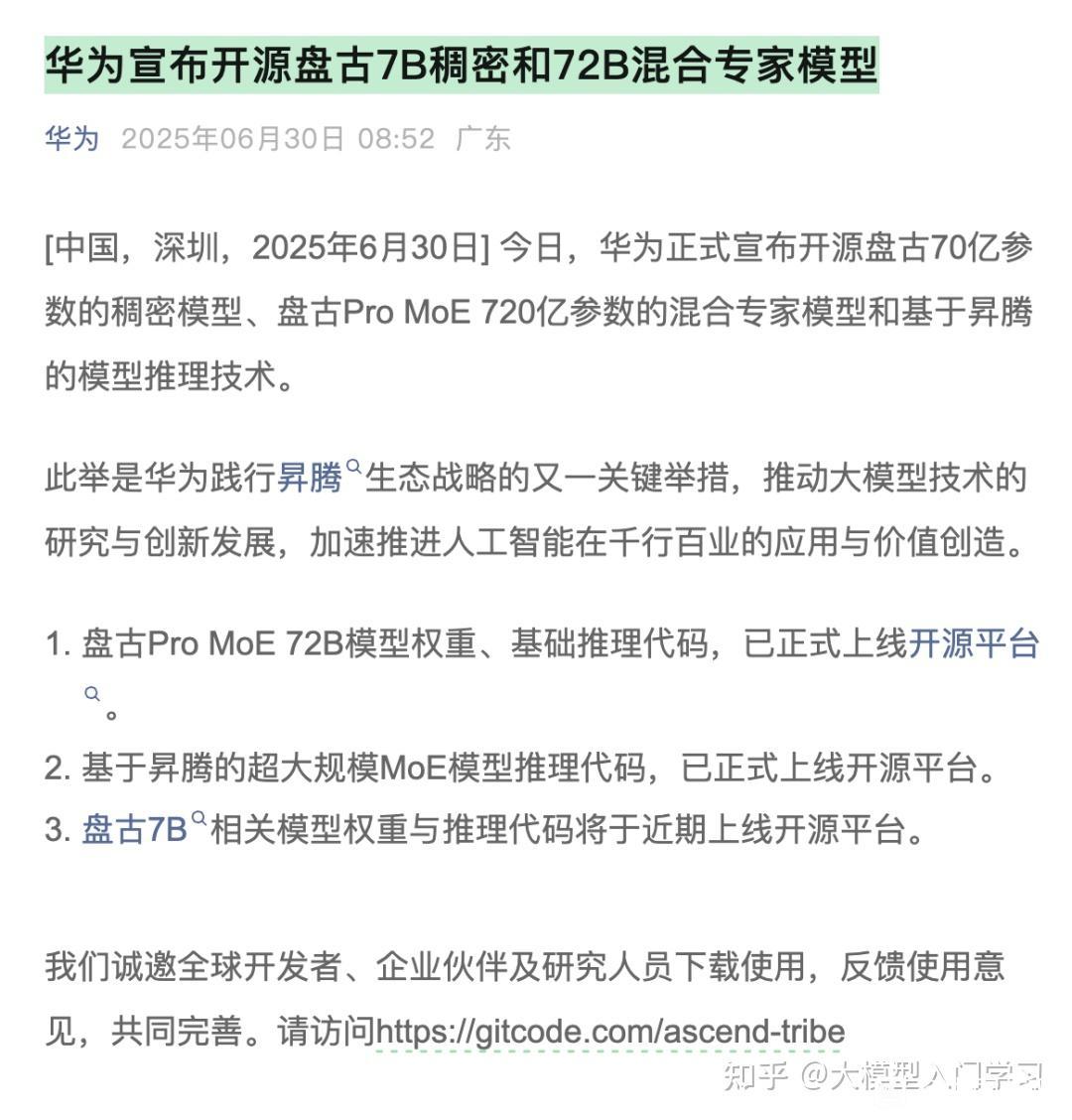

6月30日,华为宣布开源盘古70亿参数的稠密模型、盘古Pro MoE 720亿参数的混合专家模型和基于昇腾的模型推理技术。

华为表示,此举是华为践行昇腾生态战略的又一关键举措,推动大模型技术的研究与创新发展,加速推进人工智能在千行百业的应用与价值创造。

据了解,此次是华为首次将盘古大模型的核心能力开源,本次开源主要包括:盘古Pro MoE 72B模型权重、基础推理代码,已正式上线开源平台;基于昇腾的超大规模MoE模型推理代码,已正式上线开源平台;盘古7B相关模型权重与推理代码将于近期上线开源平台。

盘古大模型是华为推出的一系列超大规模人工智能预训练模型,涵盖自然语言处理、计算机视觉、科学计算等多个领域。其名称寓意“开天辟地”,象征着华为在人工智能基础研究和行业应用上的突破性探索。盘古模型自发布以来,已在多个行业中实现落地,包括金融、制造、能源、交通等,助力企业实现智能化升级。

据开源开发者平台GitGo上发布的信息,盘古Pro MoE是昇腾原生的分组混合专家模型。基于MoGE架构,华为团队构建了总参数量720亿、激活参数量160亿的盘古Pro MoE模型。

盘古Pro MoE在昇腾800I A2上实现了单卡1148 tokens/s 的推理吞吐性能,并可进一步通过投机加速等技术提升至1528 tokens/s,显著优于同等规模的320亿和720亿参数的稠密模型;在昇腾300I Duo推理服务器上,也实现了极具性价比的模型推理方案。

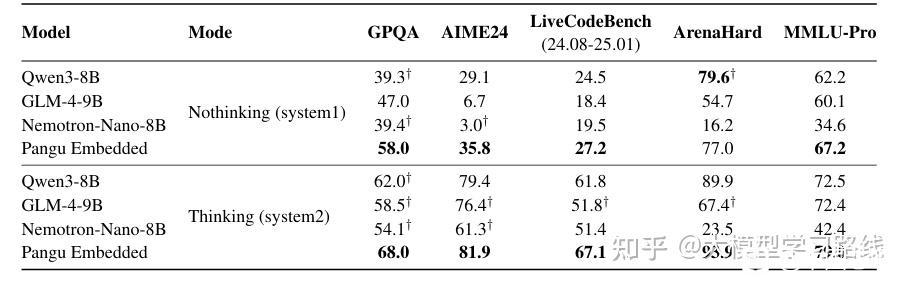

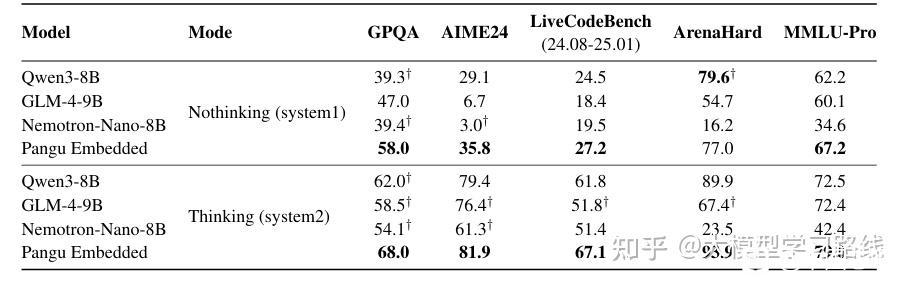

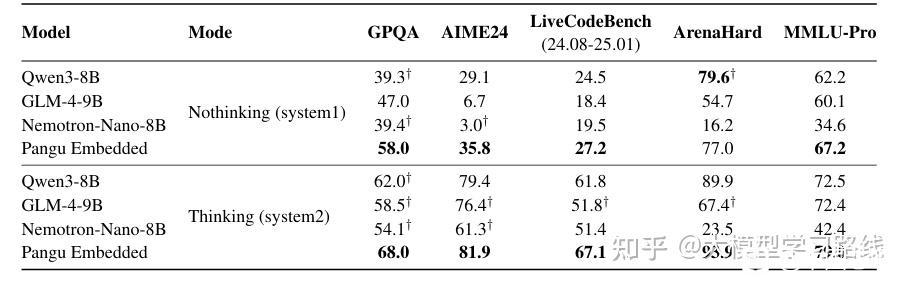

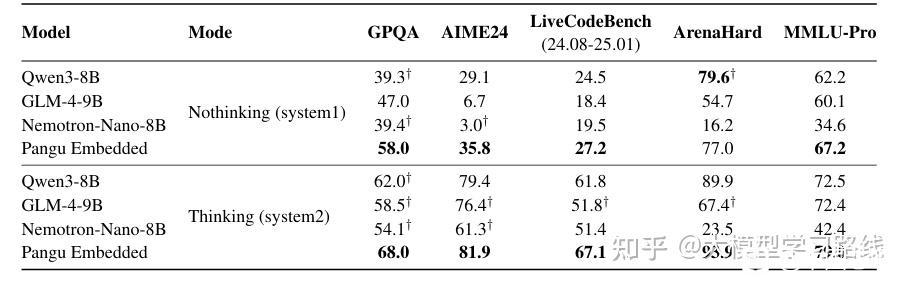

研究表明,昇腾NPU能够支持盘古Pro MoE的大规模并行训练。多项公开基准测试结果表明,盘古Pro MoE在千亿内总参数模型中处于领先地位。

自动驾驶领域,基于阿里巴巴qwen蒸馏的端侧模型的车企在下一代的智驾竞争中可以提前说拜拜啦

2025年06月30日 08点06分

1

华为表示,此举是华为践行昇腾生态战略的又一关键举措,推动大模型技术的研究与创新发展,加速推进人工智能在千行百业的应用与价值创造。

据了解,此次是华为首次将盘古大模型的核心能力开源,本次开源主要包括:盘古Pro MoE 72B模型权重、基础推理代码,已正式上线开源平台;基于昇腾的超大规模MoE模型推理代码,已正式上线开源平台;盘古7B相关模型权重与推理代码将于近期上线开源平台。

盘古大模型是华为推出的一系列超大规模人工智能预训练模型,涵盖自然语言处理、计算机视觉、科学计算等多个领域。其名称寓意“开天辟地”,象征着华为在人工智能基础研究和行业应用上的突破性探索。盘古模型自发布以来,已在多个行业中实现落地,包括金融、制造、能源、交通等,助力企业实现智能化升级。

据开源开发者平台GitGo上发布的信息,盘古Pro MoE是昇腾原生的分组混合专家模型。基于MoGE架构,华为团队构建了总参数量720亿、激活参数量160亿的盘古Pro MoE模型。

盘古Pro MoE在昇腾800I A2上实现了单卡1148 tokens/s 的推理吞吐性能,并可进一步通过投机加速等技术提升至1528 tokens/s,显著优于同等规模的320亿和720亿参数的稠密模型;在昇腾300I Duo推理服务器上,也实现了极具性价比的模型推理方案。

研究表明,昇腾NPU能够支持盘古Pro MoE的大规模并行训练。多项公开基准测试结果表明,盘古Pro MoE在千亿内总参数模型中处于领先地位。

自动驾驶领域,基于阿里巴巴qwen蒸馏的端侧模型的车企在下一代的智驾竞争中可以提前说拜拜啦