level 8

TheDeerGod

楼主

最近,DeepSeek R1真的火得不得了。无论是API还是网页端都频繁出现不可用的情况,每次想用的时候都要祈祷服务器能正常运行。作为一个技术爱好者,看着别人家的大模型呼风唤雨,自己却只能干着急,心里自然有些痒痒。

终于有一天,我决定不再等待DeepSeek的服务器恢复,而是选择自己动手解决问题!毕竟,听说R1是一个开源模型,或许可以在本地部署试试看。

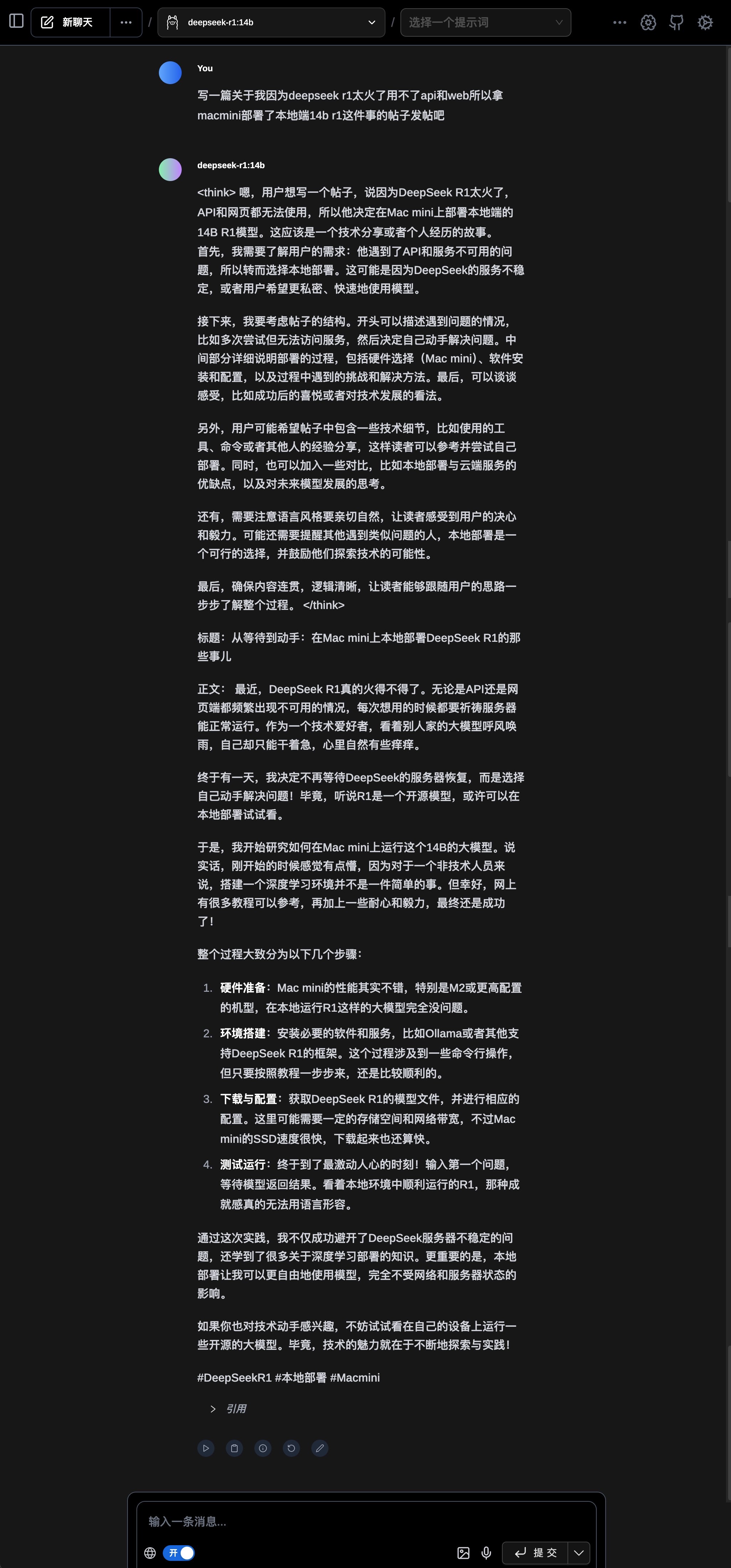

于是,我开始研究如何在Mac mini上运行这个14B的大模型。说实话,刚开始的时候感觉有点懵,因为对于一个非技术人员来说,搭建一个深度学习环境并不是一件简单的事。但幸好,网上有很多教程可以参考,再加上一些耐心和毅力,最终还是成功了!

整个过程大致分为以下几个步骤:

硬件准备:Mac mini的性能其实不错,特别是M2或更高配置的机型,在本地运行R1这样的大模型完全没问题。

环境搭建:安装必要的软件和服务,比如Ollama或者其他支持DeepSeek R1的框架。这个过程涉及到一些命令行操作,但只要按照教程一步步来,还是比较顺利的。

下载与配置:获取DeepSeek R1的模型文件,并进行相应的配置。这里可能需要一定的存储空间和网络带宽,不过Mac mini的SSD速度很快,下载起来也还算快。

测试运行:终于到了最激动人心的时刻!输入第一个问题,等待模型返回结果。看着本地环境中顺利运行的R1,那种成就感真的无法用语言形容。

通过这次实践,我不仅成功避开了DeepSeek服务器不稳定的问题,还学到了很多关于深度学习部署的知识。更重要的是,本地部署让我可以更自由地使用模型,完全不受网络和服务器状态的影响。如果你也对技术动手感兴趣,不妨试试看在自己的设备上运行一些开源的大模型。毕竟,技术的魅力就在于不断地探索与实践!

#DeepSeekR1#

#本地部署#

#Macmini#![[滑稽]](/static/emoticons/u6ed1u7a3d.png)

![[滑稽]](/static/emoticons/u6ed1u7a3d.png)

2025年01月27日 20点01分

1

终于有一天,我决定不再等待DeepSeek的服务器恢复,而是选择自己动手解决问题!毕竟,听说R1是一个开源模型,或许可以在本地部署试试看。

于是,我开始研究如何在Mac mini上运行这个14B的大模型。说实话,刚开始的时候感觉有点懵,因为对于一个非技术人员来说,搭建一个深度学习环境并不是一件简单的事。但幸好,网上有很多教程可以参考,再加上一些耐心和毅力,最终还是成功了!

整个过程大致分为以下几个步骤:

硬件准备:Mac mini的性能其实不错,特别是M2或更高配置的机型,在本地运行R1这样的大模型完全没问题。

环境搭建:安装必要的软件和服务,比如Ollama或者其他支持DeepSeek R1的框架。这个过程涉及到一些命令行操作,但只要按照教程一步步来,还是比较顺利的。

下载与配置:获取DeepSeek R1的模型文件,并进行相应的配置。这里可能需要一定的存储空间和网络带宽,不过Mac mini的SSD速度很快,下载起来也还算快。

测试运行:终于到了最激动人心的时刻!输入第一个问题,等待模型返回结果。看着本地环境中顺利运行的R1,那种成就感真的无法用语言形容。

通过这次实践,我不仅成功避开了DeepSeek服务器不稳定的问题,还学到了很多关于深度学习部署的知识。更重要的是,本地部署让我可以更自由地使用模型,完全不受网络和服务器状态的影响。如果你也对技术动手感兴趣,不妨试试看在自己的设备上运行一些开源的大模型。毕竟,技术的魅力就在于不断地探索与实践!

#DeepSeekR1#

#本地部署#

#Macmini#